Илија Суцкавер, главниот научник и еден од основачите на ОПЕН АИ како и Јан Леике, еден од двајцата шефови на тимот за супералајнмент со задача да ја контролира ВИ и да ја приспособи на потребите на човештвото дадоа отказ. Интернетот пукна – шпекулации дека е достигната не Генерална Вештачка Интелигенција, туку Вештачка Суперинтелигенција која може да биде милион пати попаметна од човекот.

Пишува: Валентин НЕШОВСКИ

Се тресе деновиве делот од интернетот кој ги покрива настаните околу Вештачката Интелигенција (ВИ). Главниот научник на Опен АИ, контроверзниот гениј, кого во јавноста го немаше од обидот за рушење на Сем Алтман, ЦЕО на Опен АИ, поднесе оставка.

Разделбата беше пријателска, со заедничка слика со главниот тим на компанијата и твит на X каде Илија им посака среќа, но додаде и „сигурен сум дека ќе создадат Генерална вештачка интелигенција“ (ГВИ). Нешто слично направи и Сем Алтман со твит каде обзнани дека Сицкавер заминува и дека го смета за „еден од најголемите умови на нашата генерација и водечко светло во полето со кое се бавиме“.

Овие две оставки се само дел од серијата научници кои последниов месец заминаа од можеби најважниот тим во рамките на Опен АИ. Всушност, откако Опен АИ го направи пробивот, веќе и не е проблем да се создаде сериозна ВИ, а доказ за тоа е што веќе има стотина сериозни компании кои имаат отворени или затворени ВИ модели. Поголем проблем со напредокот на интелигенцијата на ВИ е како таа да се усклади со вољата, потребите и сè уште доминатната етика и морал на човештвото. Тренирана на Интернет, овие големи јазични модели ги прочитаа и меморираа и најбизарните и најморбидните агли на човечката психологија и реалност, па уште од почетоците се постави прашањето „Што ако ВИ, или ГВИ или најопасно, некоја СВИ се одметне“. Стотици пати поинтелигентна и поинформирана од било кој човек или тим, би направила големи штети.

Од овие причини Опен АИ формираше тим за супералјнмент со основна цел да се обезбедат методи што ќе осигураат дека некоја идна СВИ би била безбедна. Во документ од 50тина страници што овој тим го објави на 14 декември 2023, се вели – „Неодамнешниот напредок во вештачката интелигенција е побрз отколку што речиси сите очекуваа (Штајнхард, 2022; Бенџо et al., 2023). За зголемен број на истражувачи, можноста дека суперчовечки модели ќе се развијат оваа деценија стана сè поверодостојна. Општо земено, натчовечките модели би биле извонредно моќни и, доколку се злоупотребат или не се усогласат со човечките вредности, потенцијално може да се предизвика катастрофална штета (CAIS, 2022). Со оглед на влоговите, треба да воспоставиме исклучително висока верба во усогласување на овие системи однапред. Но, со години беше нејасно како емпириски да се проучуваат и усогласат овие натчовечки модели. Ние веруваме дека сега, од кога било повеќе досега, е полесно да се постигне напредок во решавањето на овој проблем“.

Практично велат дека е опасно и дека можно е СВИ да се достигне оваа декада. Планирано било, уште велат, проблемот со супералајнмент да се реши за 4 години.

Многумина, практично, дисолуцијата на тимот ја протолкуваа во спектарот од „нешто чудно се случува“ до можноста дека Опен АИ има СВИ во лабораторија и дека недоврабата кон Сем Алтман, кој и досега беше обинуват дека е невнимателен и дека трката за доминација на пазарот му е најважна, ги натерала да заминат. Впрочем Алтман пред неколку месеци за влакно избегна „пуч“ во главниот одбор на компанијата, според некои воден и од Суцкавер, но деталите за обидот за отпуштање на Алтман останаа тајна. После оваа епизода, Алтман, според Вол Стрит Џурнал се впушти во барање 7 трилиони долари за инвестиции во инфраструктура за ВИ, која според други, би била неопходна за ГВИ па дури и за СВИ.

Со последните збиднувања тимот за супералајнмент остана десеткуван (иако Алтман веднаш го постави Џејкоб Пацочки на местото на Суцкавер) бидејќи од таму заминаа уште најмалку четворица водечки истражувачи. Лополд Ашенбренер, пријател на Суцкавер беше отпуштен минатиот месец, Павел Измаилов, беше отпуштен за неовластено протечување на информации и сега работи за Тесла, Кулен О’Кеефе, дел од тимот исто така ја напушти компанијата, а Вилијам Саундерс напиша криптичен пост на еден форум на ЕА (Ефективен алтруизам) во кој ја опиша неговата работа во полето на супералајнмент и загадочно додаде „дадов отказ на 15 февруари 24“. На прашањето зошто?, одговори „No comment”. ЕА е форум на движењето Ефективен Алтруизам создадено од повеќе истражувачи во оваа област кои се залагаат за голема претпазливост и многу бавен развој на ВИ.

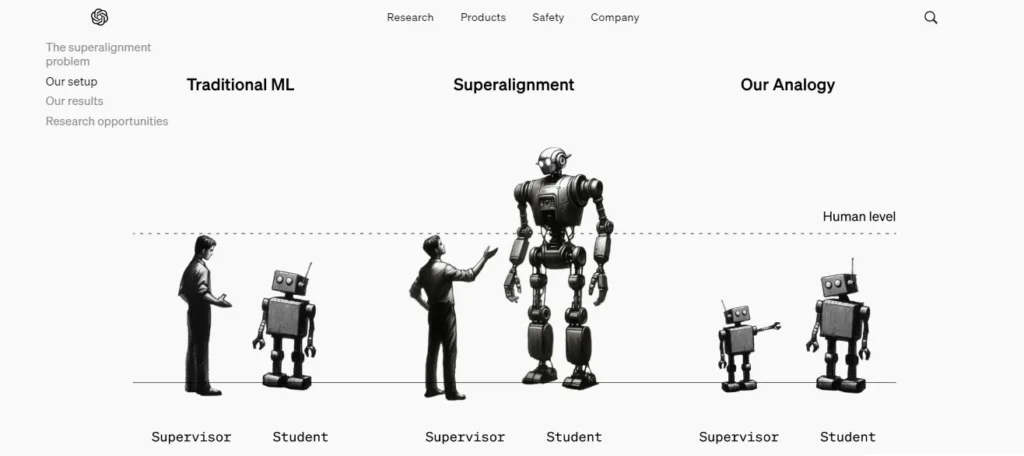

Инаку, според погоре споменатиот документ на тимот на супералајнмент, проблемот на контрола и обезбедување човечка етика и морал на евентуална СВИ, што сега се прави со reinforcement learning from human feedback (RLHF) метода, би се направило со нов модел, а тоа е GPT-n +1, односно претходниот модел ВИ би го учел наредниот модел. За илустрација – сега е актуелен GPT 4o (објавен пред една седмица), и тој би се употребил за контрола и учење на наредниот модел на пример ГПТ – 5 (види слика).

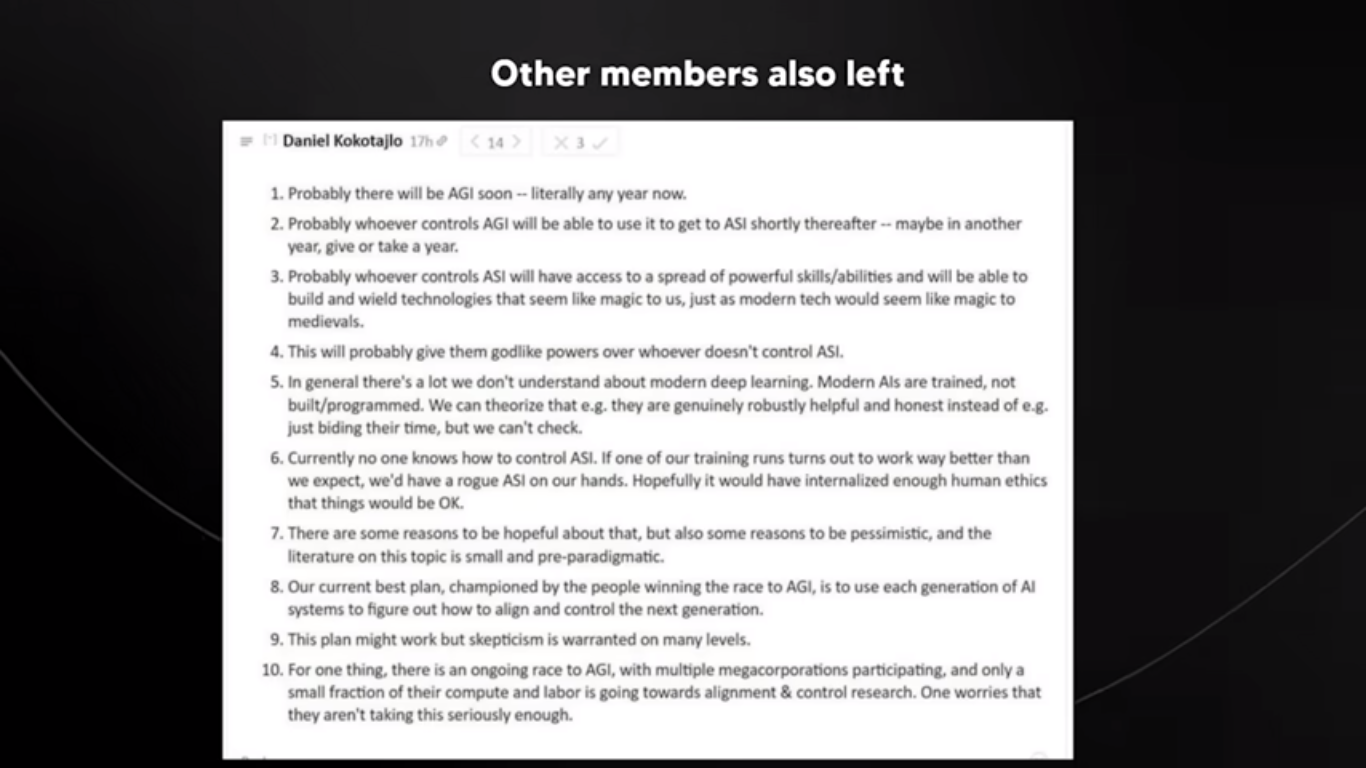

За проблемот во тимот на Опен АИ зборуваше и Даниел Кокотајло, кој работел во тимот за владеење (governonce team), кој исто така ја напушти оваа водечка компанија. Во еден пост тој зборува за способностите што СВИ би ги имала и ги споредува со магија, а во точката 4 од постот (види слика) вели дека оној што ќе има СВИ е има моќи слични на Господ.

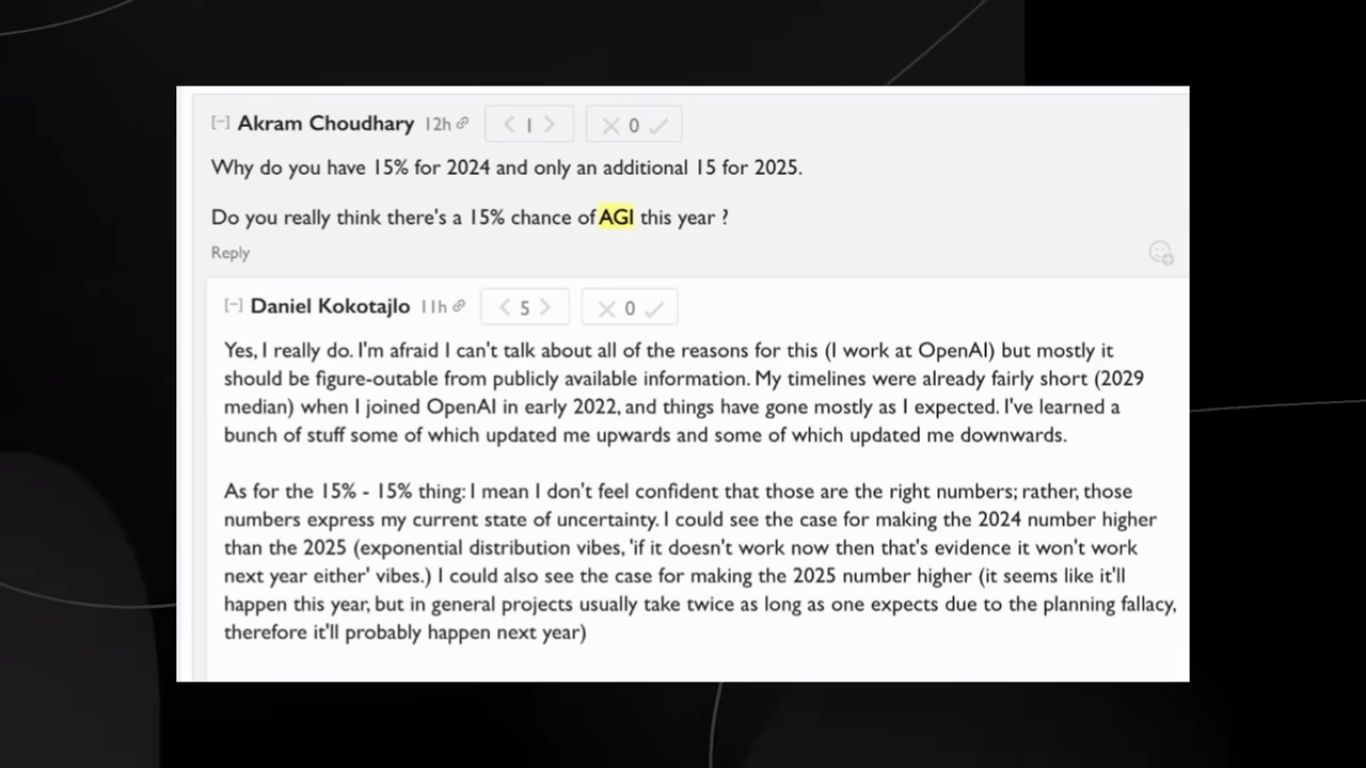

Во друг пост пак дури прогнозира дека постојат 15 отсто шанси ГВИ да се достигне ГОДИНАВА. А според многумина времетраењето на отклонот од ГВИ до СВИ ќе трае можеби секунди, можеби неколку месеци. Односно генерална човечка интелегенција со енциклопедиско знаење која работи на супермоќен компјутер веднаш би произвела нови знаења и откритија со експоненцијална брзина.

Инаку и Сем Алтман зборува од опасностите од СВИ и од важноста од супералјнмент. Во разни интервјуа вели дека ГВИ може да се достигне оваа декада, а во интервју за Грејлок вели „Би било многу лошо ако не прави тоа што ние сакаме, или има цели што или се во конфликт со нашите или не се грижат многу многу за нас луѓето. Проблемот со алјанментот е како да направиме ГВИ да работи во најдобриот интерес на луѓето“, вели Алтман. Тој зборува и за трите варијанти, да настане случајна грешка, да дојде во раце на лоши луѓе или пак да се претвори во суштество кое нас не гледа како закана.

Во меѓувреме секој ден се објавуваат нови и нови алатки базирани на ВИ, Реј Курцвел, иноватор, футуролог и ВИ истражувач вели дека до 2030 ќе се достигне бесмртност. Неговите 147 превидувања за до 2030 година досега имаат 86 отсто точност. (Фронтлајн)